La semana pasada tuve la oportunidad de dar una charla en Global AI Barcelona sobre cómo cualquiera puede montar su propio chatbot IA en local sin depender de servicios en la nube y sin tener que escribir ni una sola línea de código. Si te interesa la IA generativa pero quieres mantener el control total de tus datos y evitar costes recurrentes, aquí te dejo un resumen de lo que compartí.

¿Por qué ejecutar un chatbot IA en local?

- Privacidad: Tus datos no salen de tu máquina.

- Costo cero: No dependes de servicios cloud.

- Baja latencia: Respuestas inmediatas sin esperar a servidores externos.

- Flexibilidad: Puedes elegir qué modelos usar y cómo personalizarlos.

Herramientas clave

- Ollama: Un runtime ligero para ejecutar modelos de IA en local.

- DeepSeek & Mistral: Modelos eficientes que pueden correr en hardware modesto.

- Docker: Para simplificar la ejecución.

- OpenUIWeb: Una interfaz web para interactuar con tu chatbot sin necesidad de escribir código.

Pasos para ponerlo en marcha

Primera prueba: Chat en la consola del servidor

- Tener instalado Docker

En mi caso, como tengo un portátil modesto con Windows, utilizo Docker Desktop para virtualizar con contenedores todo lo necesario. - Descargar y ejecutar Ollama en Docker

Abrir una consola (Windows + CMD) y ejecutar:docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

- Descargar y ejecutar el modelo

docker exec -it ollama ollama run mistral

- Probar el chatbot

¡Solo tienes que preguntarle lo que quieras!

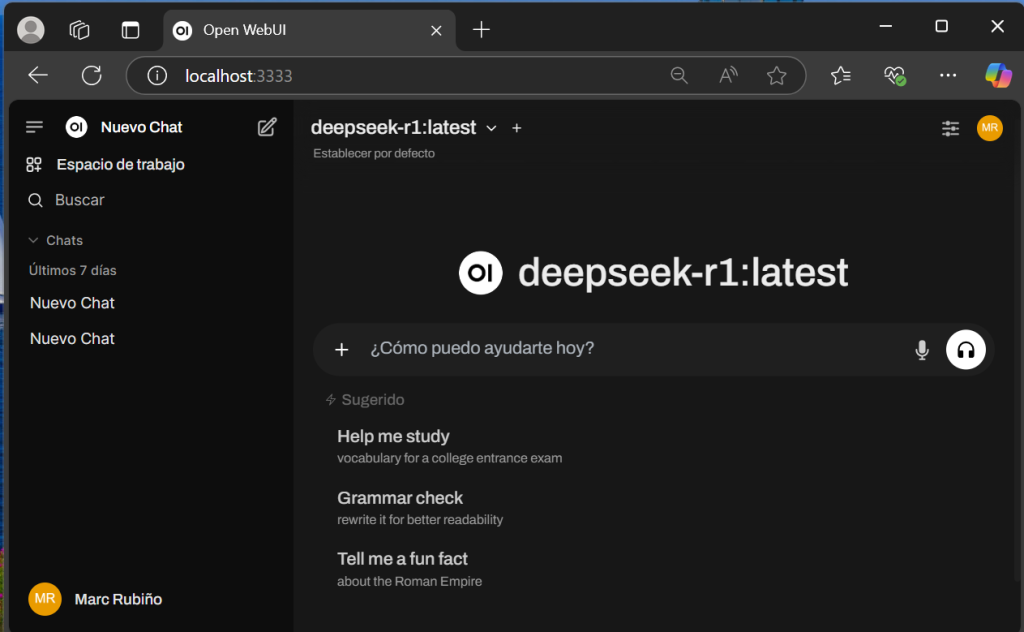

Segunda prueba: Interfaz web tipo ChatGPT

- Añadir una interfaz web

- Usa Docker Compose para levantar Ollama + OpenUIWeb juntos.

- Guarda esto como fichero docker-compose.yml

services:

ollama:

image: 'ollama/ollama:latest'

container_name: ollama

restart: unless-stopped

ports:

- "11434:11434"

volumes:

- ./models:/root/.ollama

networks:

- ollama_network

open-webui-ollama:

image: 'ghcr.io/open-webui/open-webui:main'

restart: always

container_name: open-webui-ollama

volumes:

- './open-webui:/app/backend/data'

extra_hosts:

- 'host.docker.internal:host-gateway'

ports:

- '3333:8080'

networks:

- ollama_network

networks:

ollama_network:- Levantar los contenedores

- Abrir una consola (Windows + CMD) y ejecutar:

docker exec -it ollama ollama run mistral

- Abrir una consola (Windows + CMD) y ejecutar:

- Acceder a la interfaz web

En el navegador, ir a:http://localhost:3333/ - Crear el usuario administrador

Configura tu cuenta y empieza a chatear. - ¡Disfrutar!

Esta interfaz es increíble, permite personalización y tiene historial de conversaciones sin salir de tu ordenador.

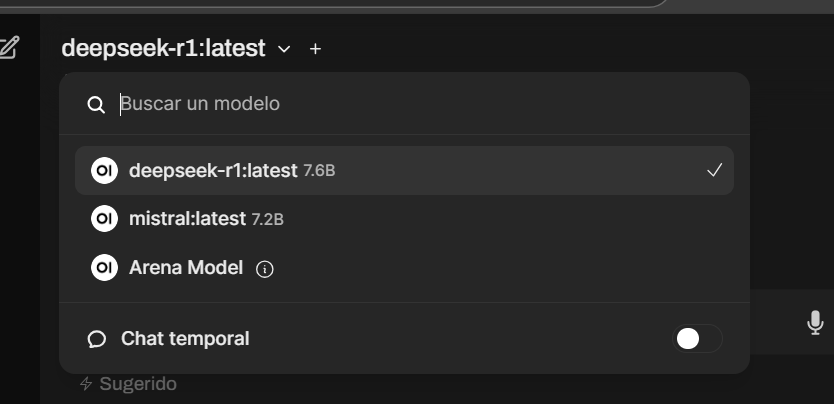

TIP

Si quieres probar otros modelos como DeepSeek, solo tienes que cargarlos y podrás utilizarlos desde tu chat. ¡Puedes tener tantos modelos como tu máquina te permita! 😉

Abrir una consola (Windows + CMD) y ejecutar: docker exec -it ollama ollama pull deepseek-R1

La combinación de Ollama + Mistral o DeepSeek permite tener un sistema IA funcional en minutos, accesible desde cualquier navegador.

Si te interesa más contenido como este, déjame tu feedback o dime qué otros temas de IA te gustaría que exploremos en próximas ediciones.